Война ИИ-технологий — способы идентификации дипфейка и войсклонов

Как распознать фейки и какие инструменты в этом помогут — в колонке для AdIndex рассказывает Алексей Парфун, СEO Agenda Media Group

Скорее всего, вы в курсе: дипфейк и клонирование голоса уже вокруг нас. Сальвадор Дали общается с ценителями его искусства, Дэвид Бэкхем говорит на девяти языках, а звезда «Перевозчика» Джейсон Стэйтем празднует 60-летие в России со своими голливудскими друзьями.

Актриса дубляжа Алена Андронова озвучила большой массив текста для коммерческого заказчика, а в итоге услышала себя в порно и лишилась части работы.

Копии артистов активно снимаются в кино, делая их моложе. Но сейчас мы с вами говорим о позитивных примерах. Очевидно, что есть и обратная сторона технологического процесса. Мошенничество, фишинг, социальная инженерия, вторжение в частную жизнь, угрозы биометрической аутентификации — это далеко не полный список возникающих рисков.

Алексей Парфун попытается ответить на наиболее частый вопрос: «Что с этим делать и как себя защитить?»

Распознавание дипфейка

Первый совет: посмотрите внимательно на видео. Как человек, сталкивающийся с дипфейками ежедневно, я, очевидно, быстрее их замечаю, но, уверяю вас, даже неподготовленный пользователь всегда сможет отличить фейковое видео, если приглядится внимательно.

Обратите внимание на мелкие несоответствия и отклонения. Это могут быть неестественные жесты губ и бровей, неправильные интервалы моргания, неравномерное освещение, различия в оттенках кожи, зернистая детализация изображения, нечеткие границы наложенных элементов и другие незаметные мелочи. Обычно к дублеру применяют замену лица, а не всей головы, и на краю лица, вдоль линии подбородка и волос видно небольшое замыливание изображения — обращайте на это внимание.

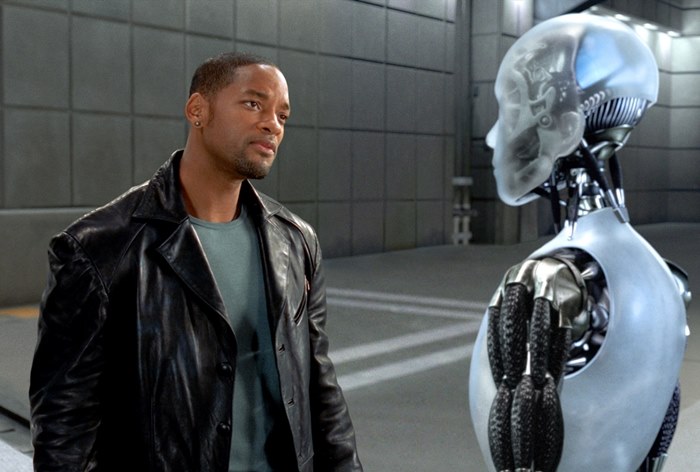

Второй совет чуть более абстрактен, но, с моей точки зрения, вполне эффективен. Человек как вид существует сотни тысяч лет, и первые отделы мозга у него развивались так же, как у животных, — на уровне инстинктов. Благодаря этому мы, собственно, и выжили.

Так вот, с моей точки зрения, при просмотре видео, в котором использован дипфейк, крайне часто возникает так называемый «эффект зловещей долины». Этот эффект проявляется, когда искусственный объект, который стремится выглядеть как человек, не совсем достигает реализма и, вместо того чтобы вызывать положительные эмоции, он вызывает чувство неприязни или даже страха. Прислушайтесь к своей интуиции, она редко вас обманывает.

Ну и наконец, наиболее очевидный третий совет: пользуйтесь техническими средствами определения дипфейк-видео. Их уже немало, и постоянно появляются новые.

Вот наиболее актуальный на начало 2024 года список:

- KaiCatch: распознает аномалии и искажения в фото и видео при помощи искусственного интеллекта.

- Microsoft Video Authenticator: оценивает фото и видео, определяя вероятность монтажа.

- Sentinel: система позволяет пользователям загружать цифровые мультимедийные файлы через свой веб-сайт или API.

- FakeCatcher: эта технология может обнаруживать поддельные видео с точностью 96%, возвращая результаты за миллисекунды.

- WeVerify: проект ориентирован на анализ и контекстуализацию социальных сетей и веб-контента в расширенной онлайн-экосистеме с целью выявления поддельного контента.

- Truepic: проверяет фото и видео на наличие внесенных изменений.

Аудиофейки

Обнаружение аудиодипфейков представляет собой более сложную задачу по сравнению с их созданием, которое, к слову, не требует особых усилий: для синтеза такого поддельного аудио обычно достаточно наличия аудиозаписи оригинального голоса.

Существуют разработки, которые позволяют редактировать аудиозаписи подобно обработке обычного текста. Не так давно перед участием в подкасте «Киберэтика» AI-инженеры Agenda Media за несколько часов сделали вполне правдоподобный клон голоса моего собеседника. Любой технически подготовленный энтузиаст может повторить это в домашних условиях — достаточно иметь под рукой запись пары часов голоса объекта копирования.

Распознать фальшивый голос без использования дополнительных инструментов представляется сложной задачей. Ученые предложили метод, основанный на воздействии на речь анатомических особенностей голосового аппарата человека, таких как голосовые связки, язык, челюсти и губы. Суть заключается в том, что при генерации звуков с использованием искусственного интеллекта такие физические особенности не учитываются. Аудиодипфейк часто включает звуки, которые физиологически невозможно воспроизвести человеческим голосовым аппаратом.

Для проверки и обработки аудиофайлов вы можете воспользоваться легким и бесплатным инструментом Audacity. При загрузке файла вам сразу станут видны визуальные индикаторы подозрительных моментов, на которые стоит обратить внимание. Помимо этого, существуют специализированные платные программы, например Phonexi-Pro или OTExper. Их среди прочего используют для судебной аудиоэкспертизы.

Ну и основной совет, который я даю всегда: главный навык 21-го века — навык критического мышления.

Вот несколько советов по его применению:

- всегда ищите альтернативные источники данных. Посмотрите, есть ли в серьезных СМИ фото папы римского в пуховике «Баленсиага» или их публикует только непонятный аккаунт в Твиттере;

- сопоставляйте контекст. Убедитесь, что информация из альтернативного источника и проверяемого источника касается одних и тех же событий или фактов;

- проверяйте данные факта. Для проверки видеофрагмента можно использовать альтернативный поток данных, представленный фотографиями или видео из социальных сетей того же места (возможно, с участием других людей).

Фейки будут появляться все чаще, с развитием доступности технологии их поток будет только увеличиваться. Для эффективного противостояния им каждому из нас стоит создать замкнутый цикл обработки поступающей информации по аналогии с тем, как это реализовано в системах управления данными. Это могут быть настройки в браузере, специальный софт, различные новые разработки, которые еще не вышли на рынок. Пословица про «береженого Бог бережет» по-прежнему актуальна.